0

| 本文作者: AI研習(xí)社 | 2020-03-16 14:29 |

深度上下文感知移動(dòng)活動(dòng)識(shí)別和未知上下文發(fā)現(xiàn)的不確定性量化

StereoNet:基于引導(dǎo)分層優(yōu)化的實(shí)時(shí)邊緣感知深度預(yù)測(cè)

移動(dòng)設(shè)備上的任意時(shí)間雙目深度估計(jì)

實(shí)時(shí)自適應(yīng)深度立體匹配

CNN合成的圖片現(xiàn)在能輕松鑒別了

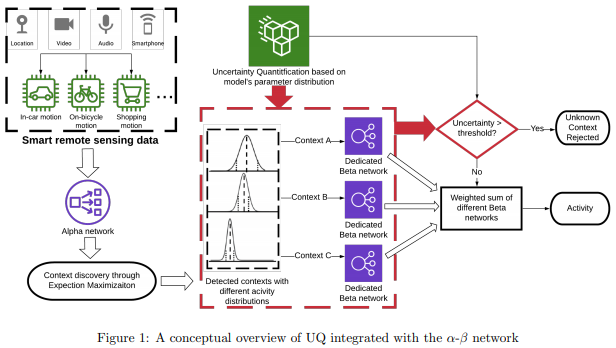

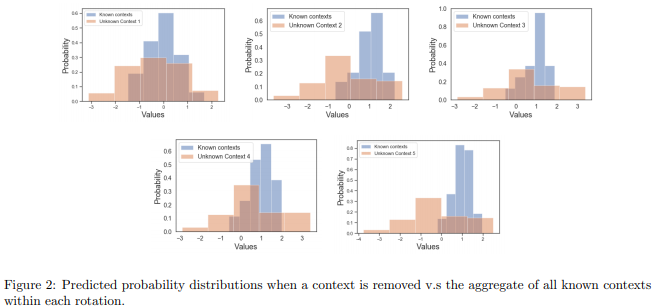

論文名稱:Uncertainty Quantification for Deep Context-Aware Mobile Activity Recognition and Unknown Context Discovery

作者:Huo Zepeng /PakBin Arash /Chen Xiaohan /Hurley Nathan /Yuan Ye /Qian Xiaoning /Wang Zhangyang /Huang Shuai /Mortazavi Bobak

發(fā)表時(shí)間:2020/3/3

論文鏈接:https://paper.yanxishe.com/review/13410?from=leiphonecolumn_paperreview0316

推薦原因

這篇論文被AISTATS 2020接收,考慮的是可穿戴計(jì)算中的活動(dòng)識(shí)別問(wèn)題。

在這個(gè)問(wèn)題中,活動(dòng)特征可能取決于上下文,而且未知上下文和活動(dòng)可能會(huì)不時(shí)發(fā)生,這需要算法具有靈活性和適應(yīng)性。這篇論文提出了一種上下文感知混合模型,稱為深度模型α-β網(wǎng)絡(luò),結(jié)合了基于最大熵的不確定性量化以增強(qiáng)人類活動(dòng)識(shí)別的性能。通過(guò)以數(shù)據(jù)驅(qū)動(dòng)的方式識(shí)別高層級(jí)上下文來(lái)指導(dǎo)模型開發(fā),新模型將準(zhǔn)確率和F值提高了10%。為確保訓(xùn)練穩(wěn)定性,這篇論文在公共和內(nèi)部數(shù)據(jù)集中都使用了基于聚類的預(yù)訓(xùn)練,以證明通過(guò)未知上下文發(fā)現(xiàn)可以提高準(zhǔn)確率。

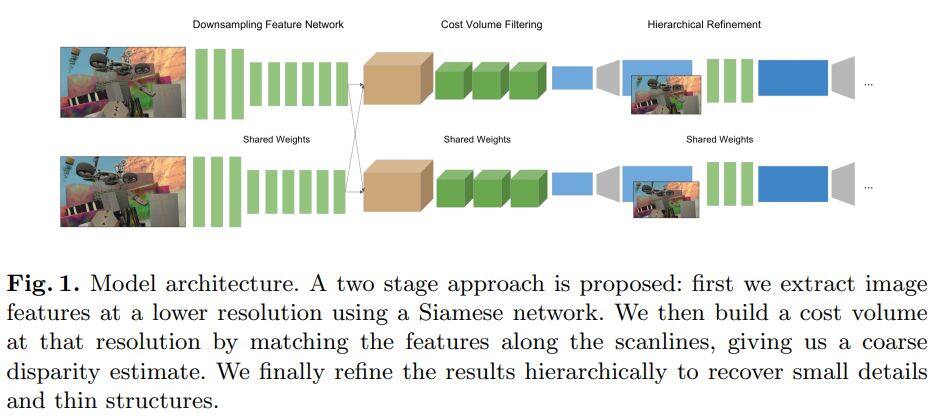

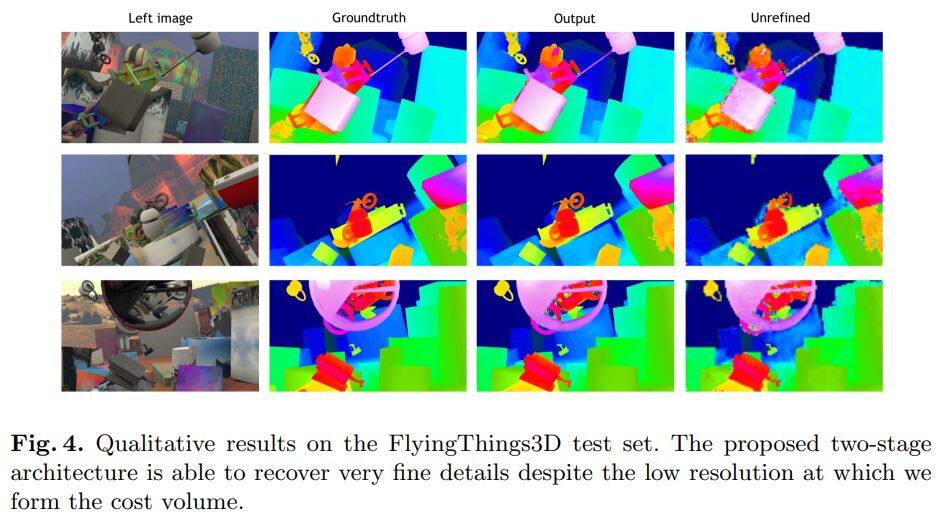

論文名稱:StereoNet: Guided Hierarchical Refinement for Real-Time Edge-Aware Depth Prediction

作者:Khamis Sameh /Fanello Sean /Rhemann Christoph /Kowdle Adarsh /Valentin Julien /Izadi Shahram

發(fā)表時(shí)間:2018/7/24

論文鏈接:https://paper.yanxishe.com/review/13540?from=leiphonecolumn_paperreview0316

推薦原因

這篇論文提出了第一個(gè)實(shí)時(shí)的雙目深度估計(jì)網(wǎng)絡(luò)StereoNet,能夠在英偉達(dá)Titan X上達(dá)到60FPS。論文的亮點(diǎn)主要在網(wǎng)絡(luò)結(jié)構(gòu)的設(shè)計(jì)上,StereoNet屬于基于3D卷積的立體匹配,cost volume的大小決定了網(wǎng)絡(luò)的參數(shù)量和推理速度。作者發(fā)現(xiàn)可以把cost volume設(shè)計(jì)的比較小,但是它仍然包含了較多的特征信息,只會(huì)有較少的精度損失。這樣網(wǎng)絡(luò)可以先得到一個(gè)粗糙的視差圖。之后作者設(shè)計(jì)了一種層次化的,邊緣敏感的精修網(wǎng)絡(luò),實(shí)際上是利用卷積網(wǎng)絡(luò)估計(jì)殘差,利用殘差和粗糙的視差圖分層優(yōu)化,得到更加細(xì)致的,保留邊緣的視差圖。該論文收錄在ECCV 2018上,是首次實(shí)現(xiàn)實(shí)時(shí)的雙目深度估計(jì)。

論文名稱:Anytime Stereo Image Depth Estimation on Mobile Devices

作者:Wang Yan /Lai Zihang /Huang Gao /Wang Brian H. /van der Maaten Laurens /Campbell Mark /Weinberger Kilian Q.

發(fā)表時(shí)間:2018/10/26

論文鏈接:https://paper.yanxishe.com/review/13539?from=leiphonecolumn_paperreview0316

推薦原因

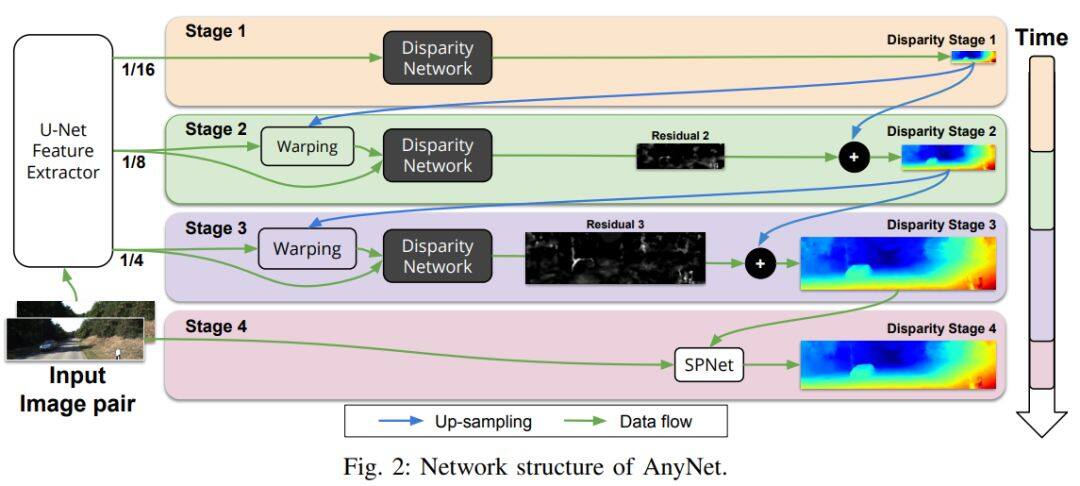

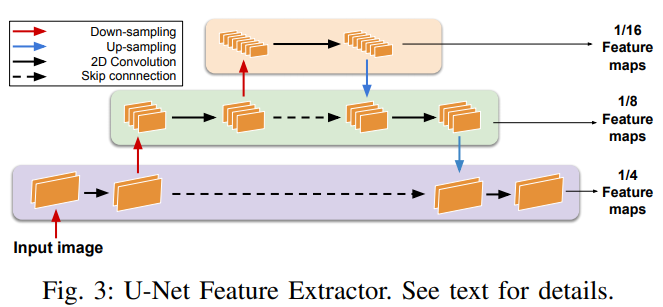

這篇論文提出了一個(gè)可以在移動(dòng)設(shè)備上實(shí)時(shí)運(yùn)行的雙目深度估計(jì)網(wǎng)絡(luò)。作者觀察發(fā)現(xiàn)深度網(wǎng)絡(luò)中圖像的分辨率大小和需要考慮的最大視差值是影響雙目深度估計(jì)網(wǎng)絡(luò)推理速度的兩個(gè)因素。以此為依據(jù),作者設(shè)計(jì)了一個(gè)多階段的視差估計(jì)網(wǎng)絡(luò)AnyNet,可以在不同的時(shí)間限制下達(dá)到不同程度的精度。使用的階段越少,推理速度越快,相應(yīng)的準(zhǔn)確率就越低。AnyNet只在第一個(gè)階段估計(jì)視差,之后的階段僅估計(jì)殘差,這樣能夠提高推理速度。作者還發(fā)現(xiàn)最后一個(gè)階段使用SPNet能夠獲得更加精細(xì)的視差圖。論文收錄在ICRA 2019上,比StereoNet速度更快,精度更高,能夠應(yīng)用于移動(dòng)設(shè)備上,可以為工業(yè)界提供較好的學(xué)術(shù)基礎(chǔ)。

論文名稱:Real-time self-adaptive deep stereo

作者:Tonioni Alessio /Tosi Fabio /Poggi Matteo /Mattoccia Stefano /Di Stefano Luigi

發(fā)表時(shí)間:2018/10/12

論文鏈接:https://paper.yanxishe.com/review/13538?from=leiphonecolumn_paperreview0316

推薦原因

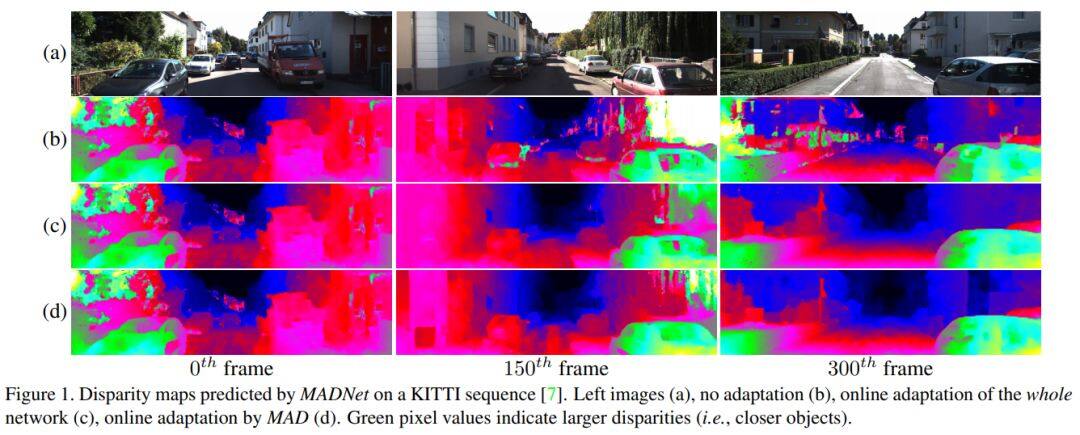

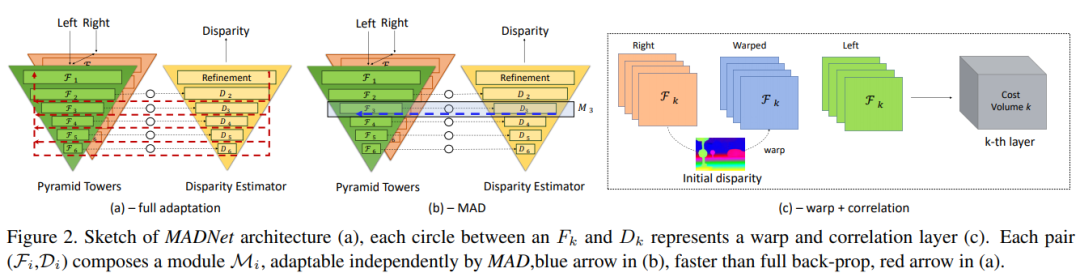

論文提出了第一個(gè)實(shí)時(shí)的自適應(yīng)的深度立體匹配網(wǎng)絡(luò)MADNet。作者設(shè)計(jì)了一個(gè)編碼-解碼網(wǎng)絡(luò)作為視差估計(jì)網(wǎng)絡(luò),編碼部分是一個(gè)自上而下的金字塔結(jié)構(gòu),而解碼部分是一個(gè)自下而上的金字塔結(jié)構(gòu),每個(gè)部分共6層,每層輸出不同分辨率的預(yù)測(cè)視差。傳統(tǒng)的完全自適應(yīng)是采用無(wú)監(jiān)督損失函數(shù)直接反向傳播,但是這種訓(xùn)練方法在要求實(shí)時(shí)環(huán)境下計(jì)算量太大。作者設(shè)計(jì)了一個(gè)自適應(yīng)調(diào)制模塊(MAD),采用啟發(fā)式的方法每次只選擇一種分辨率的分支進(jìn)行反向傳播,這樣比整個(gè)網(wǎng)絡(luò)都進(jìn)行反向傳播要快很多。MADNet的視差估計(jì)速度達(dá)到40FPS,在線自適應(yīng)速度達(dá)到15FPS,是在實(shí)時(shí)自適應(yīng)深度網(wǎng)絡(luò)上邁出的第一步。論文為CVPR 2019 Oral。

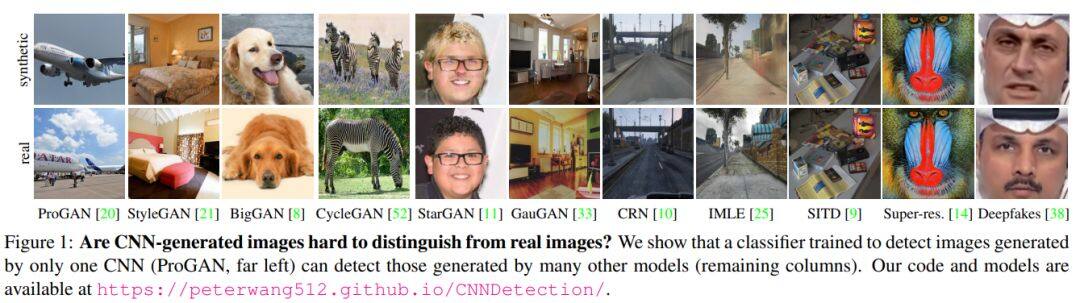

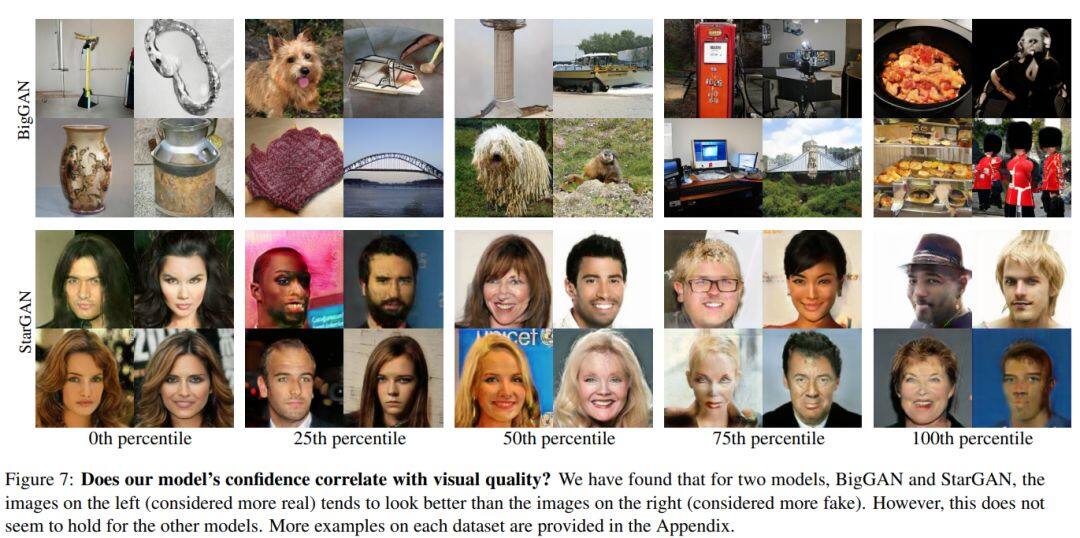

論文名稱:CNN-generated images are surprisingly easy to spot... for now

作者:Wang Sheng-Yu /Wang Oliver /Zhang Richard /Owens Andrew /Efros Alexei A.

發(fā)表時(shí)間:2019/12/23

論文鏈接:https://paper.yanxishe.com/review/13535?from=leiphonecolumn_paperreview0316

推薦原因

這篇論文主要探索如何利用單一的GAN模型來(lái)鑒別其他各種GAN生成的圖像。無(wú)論各種GAN生成的圖像是何種類型,使用何種網(wǎng)絡(luò)結(jié)構(gòu),合成的假圖都用相同的缺陷。作者首先利用11種GAN模型來(lái)構(gòu)造一個(gè)大規(guī)模的合成圖像鑒別數(shù)據(jù)庫(kù),F(xiàn)orenSynths Datsets。之后僅僅利用單一的ProGAN模型來(lái)訓(xùn)練,就能夠在ForenSynths上表現(xiàn)出良好的泛化性能,甚至可以打敗新出的StyleGAN2和DeepFake。作者通過(guò)實(shí)驗(yàn)表明數(shù)據(jù)增強(qiáng)作為后處理方法,以及訓(xùn)練數(shù)據(jù)的多樣性是成功的關(guān)鍵,尤其是數(shù)據(jù)增強(qiáng)使得訓(xùn)練一個(gè)鑒別器就有良好的泛化能力和魯棒性。這篇論文收錄在CVPR 2020,是反造假技術(shù)再進(jìn)一步的標(biāo)志。造假和反造假技術(shù)一直在共同進(jìn)步。

雷鋒網(wǎng)雷鋒網(wǎng)雷鋒網(wǎng)

相關(guān)文章:

雷峰網(wǎng)原創(chuàng)文章,未經(jīng)授權(quán)禁止轉(zhuǎn)載。詳情見(jiàn)轉(zhuǎn)載須知。