0

| 本文作者: AI研習(xí)社 | 2020-03-23 14:39 |

CVPR 2020 | Social-STGCNN:一種用于行人軌跡預(yù)測的社會(huì)時(shí)空圖卷積神經(jīng)網(wǎng)絡(luò)

CVPR 2020 | 基于有偏訓(xùn)練的無偏場景圖生成

CVPR 2020 | 面向深度人臉識(shí)別的通用表征學(xué)習(xí)

CVPR 2020 | 使用多個(gè)攝像機(jī)的實(shí)時(shí)多人運(yùn)動(dòng)捕捉的4D關(guān)聯(lián)圖

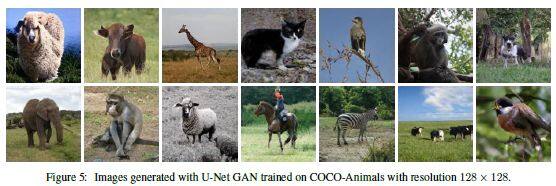

CVPR 2020 | 一種基于U-Net的生成性對抗網(wǎng)絡(luò)判別器

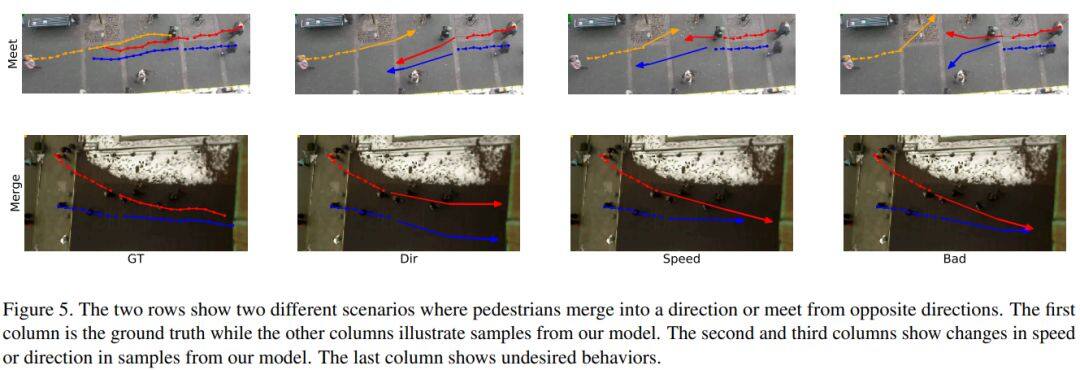

論文名稱:Social-STGCNN: A Social Spatio-Temporal Graph Convolutional Neural Network for Human Trajectory Prediction

作者:Mohamed Abduallah /Qian Kun /Elhoseiny Mohamed /Claudel Christian

發(fā)表時(shí)間:2020/2/27

論文鏈接:https://arxiv.org/abs/2002.11927?from=leiphonecolumn_paperreview0323

推薦原因

這篇論文被CVPR 2020接收,考慮的是行人軌跡預(yù)測的問題。

行人軌跡不僅受行人本身影響,還與周圍物體的相互作用有關(guān)。這篇論文提出了社會(huì)時(shí)空圖卷積神經(jīng)網(wǎng)絡(luò)(Social Spatio-Temporal Graph Convolutional Neural Network,Social-STGCNN),將行人與周圍物體的交互行為建模為圖模型,并通過一個(gè)核函數(shù)將行人之間的社交互動(dòng)嵌入鄰接矩陣中。實(shí)驗(yàn)結(jié)果表明,與先前方法相比,Social-STGCNN的最終位移誤差較現(xiàn)有技術(shù)提高了20%,參數(shù)減少了8.5倍,而推理速度提高了48倍。

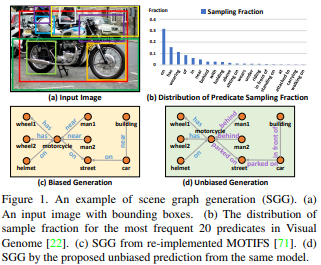

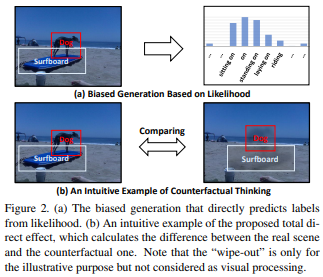

論文名稱:Unbiased Scene Graph Generation from Biased Training

作者:Tang Kaihua /Niu Yulei /Huang Jianqiang /Shi Jiaxin /Zhang Hanwang

發(fā)表時(shí)間:2020/2/27

論文鏈接:https://arxiv.org/abs/2002.11949?from=leiphonecolumn_paperreview0323

推薦原因

這篇論文被CVPR 2020接收,要解決的是場景圖生成的問題。

已有的場景圖生成容易受有訓(xùn)練偏見的問題,例如將海灘上人類的步行、坐、躺等多樣行為類型籠統(tǒng)分為海灘上的人類。這篇論文提出了一種新的基于因果推理的場景圖生成的框架。首先建立因果圖,然后使用該圖進(jìn)行傳統(tǒng)的有偏訓(xùn)練,接著從訓(xùn)練圖上得出反事實(shí)因果關(guān)系,以從不良偏置中推斷出影響并將其消除。場景生成基準(zhǔn)集Visual Genome上的實(shí)驗(yàn)表明這篇論文所提的方法與以前的最佳方法相比有顯著改進(jìn)。

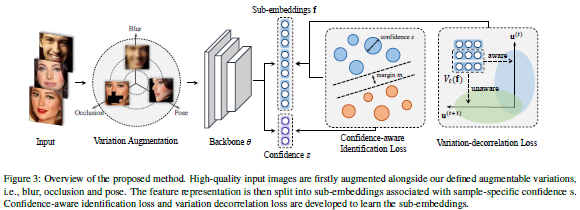

論文名稱:Towards Universal Representation Learning for Deep Face Recognition

作者:Shi Yichun /Yu Xiang /Sohn Kihyuk /Chandraker Manmohan /Jain Anil K.

發(fā)表時(shí)間:2020/2/26

論文鏈接:https://arxiv.org/abs/2002.11841?from=leiphonecolumn_paperreview0323

推薦原因

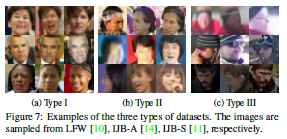

這篇論文被CVPR 2020接收,提出了一種面向深度人臉識(shí)別的通用表征學(xué)習(xí)框架,可以處理給定訓(xùn)練數(shù)據(jù)中未發(fā)現(xiàn)的較大變化,而無需利用目標(biāo)域知識(shí)。新框架首先將訓(xùn)練數(shù)據(jù)與一些有意義的語義變化(例如低分辨率、遮擋和頭部姿勢)一起合成。訓(xùn)練過程中將特征嵌入拆分為多個(gè)子嵌入,并為每個(gè)子嵌入關(guān)聯(lián)不同的置信度值,以簡化訓(xùn)練過程。通過對變化的分類損失和對抗性損失進(jìn)行正則化,可進(jìn)一步對子嵌入進(jìn)行解相關(guān)。實(shí)驗(yàn)表明,新的框架在LFW和MegaFace等常規(guī)人臉識(shí)別數(shù)據(jù)集上均取得最佳性能,而在TinyFace和IJB-S等極端基準(zhǔn)集上則明顯優(yōu)于對比算法。

論文名稱:4D Association Graph for Realtime Multi-person Motion Capture Using Multiple Video Cameras

作者:Zhang Yuxiang /An Liang /Yu Tao /Li Xiu /Li Kun /Liu Yebin

發(fā)表時(shí)間:2020/2/28

論文鏈接:https://arxiv.org/abs/2002.12625?from=leiphonecolumn_paperreview0323

推薦原因

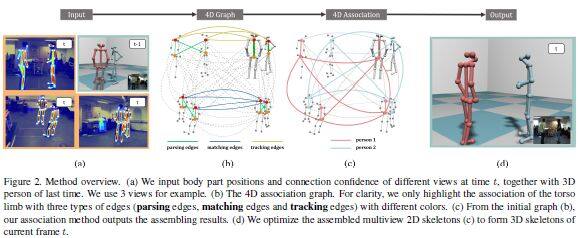

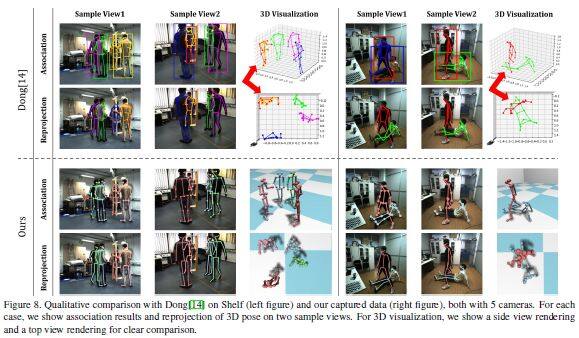

這篇論文被CVPR 2020接收,提出了一種新的使用多視點(diǎn)視頻輸入的實(shí)時(shí)多人運(yùn)動(dòng)捕捉算法,首次將視圖解析、跨視圖匹配和時(shí)間跟蹤整合到一個(gè)優(yōu)化框架中,即得到一個(gè)4D關(guān)聯(lián)圖,該圖可以同時(shí)平等地處理每個(gè)維度(圖像空間、視點(diǎn)和時(shí)間)。為有效求解4D關(guān)聯(lián)圖,這篇論文進(jìn)一步提出基于啟發(fā)式搜索的4D肢束解析思想,然后通過提出束Kruskal算法對肢束進(jìn)行組合。這個(gè)新算法可以在5人場景中使用5個(gè)攝像機(jī),以30fps的速度運(yùn)行實(shí)時(shí)在線運(yùn)動(dòng)捕捉系統(tǒng)。新算法不僅對噪聲檢測具有魯棒性,還獲得了高質(zhì)量的在線姿態(tài)重建結(jié)果。在不使用高級(jí)外觀信息的情況下,新算法優(yōu)于當(dāng)前最優(yōu)方法。

論文名稱:A U-Net Based Discriminator for Generative Adversarial Networks

作者:Sch?nfeld Edgar /Schiele Bernt /Khoreva Anna

發(fā)表時(shí)間:2020/2/28

論文鏈接:https://arxiv.org/abs/2002.12655?from=leiphonecolumn_paperreview0323

推薦原因

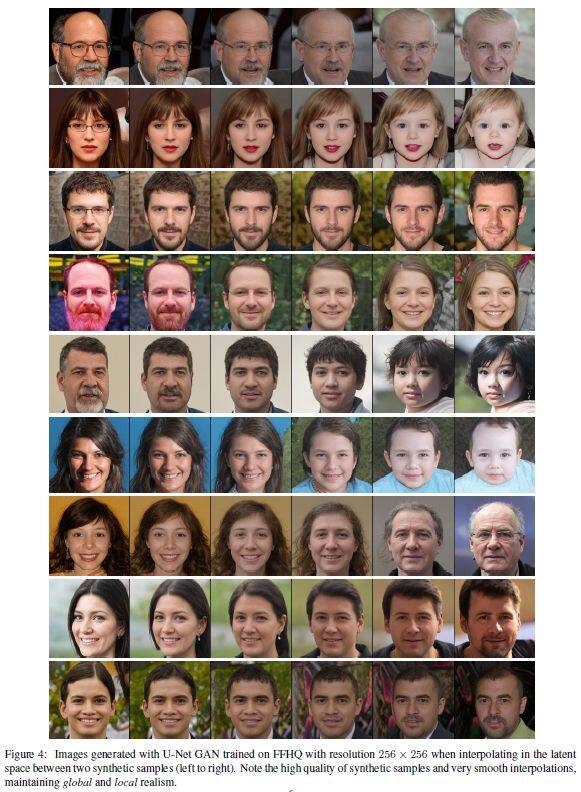

這篇論文被CVPR 2020接收,提出了一種基于U-Net的判別器架構(gòu),在保持合成圖像的全局一致性的同時(shí),向生成器提供詳細(xì)的每像素反饋。在判別器的每像素響應(yīng)支持下,這篇論文進(jìn)一步提出一種基于CutMix數(shù)據(jù)增強(qiáng)的逐像素一致性正則化技術(shù),鼓勵(lì)U-Net判別器更多關(guān)注真實(shí)圖像與偽圖像之間的語義和結(jié)構(gòu)變化,不僅改善了U-Net判別器的訓(xùn)練,還提高了生成樣本的質(zhì)量。新判別器在標(biāo)準(zhǔn)分布和圖像質(zhì)量指標(biāo)方面改進(jìn)了現(xiàn)有技術(shù),使生成器能夠合成具有變化結(jié)構(gòu)、外觀和詳細(xì)程度的圖像,并保持全局和局部真實(shí)感。與BigGAN基線模型相比,所提方法在FFHQ、CelebA和COCO-Animals數(shù)據(jù)集上平均提高了2.7個(gè)FID點(diǎn)。

雷鋒網(wǎng)雷鋒網(wǎng)雷鋒網(wǎng)

相關(guān)文章:

今日 Paper | 視覺目標(biāo);聯(lián)合學(xué)習(xí);面部反欺;在元學(xué)習(xí)等

雷峰網(wǎng)原創(chuàng)文章,未經(jīng)授權(quán)禁止轉(zhuǎn)載。詳情見轉(zhuǎn)載須知。